关于DeepSeek,多家算力芯片公司宣布……

春节假期期间,DeepSeek的爆火如“平地一声雷”。这家于2023年成立的人工智能基础技术研究企业,在今年1月20日正式开源其R1推理模型,该模型在数学、代码、自然语言推理等任务上,性能比肩OpenAI-o1正式版,且开发成本仅为600万美元,仅相当于OpenAI-o1 模型开发成本的1.2% 。DeepSeek于2024年12月26日宣布上线并同步开源的DeepSeek-V3模型,以1/11的算力、仅2000个GPU芯片训练出性能超越GPT-4o的大模型,且训练成本仅相当于GPT-4o的5.6%。

业内人士表示,DeepSeek此举开拓出高性能模型训练的新思路,其以低成本实现大模型训练,也引发了业界对海外AI企业耗费巨量算力资源训练模型必要性的怀疑。近日,多家中外算力芯片企业纷纷发布适配DeepSeek模型的消息。

龙芯中科:宣布实现DeepSeek大模型本地化部署

DeepSeek成功部署于诚迈信创电脑

2月7日,龙芯中科宣布,搭载龙芯3号CPU的设备成功启动运行DeepSeek R1 7B模型,实现本地化部署,可为广大用户提供更快、更强、更省的训推体验。日前,龙芯联合太初元碁等产业伙伴,仅用2小时即在太初T100加速卡上完成DeepSeek-R1系列模型的适配工作,快速上线包含DeepSeek-R1-Distill-Qwen-7B在内的多款大模型服务。此外,采用龙芯3A6000处理器的诚迈信创电脑和望龙电脑已实现本地部署DeepSeek,部署后无需依赖云端服务器,避免了因网络波动或服务器过载导致的服务中断,可高效完成文档处理、数据分析、内容创作等工作。目前,龙芯正积极携手太初元碁、寒武纪、天数智芯、算能科技、openEuler等合作伙伴,全力打造DeepSeek系列模型的多形态推理平台,助力企业用户实现智能化转型。

燧原科技:实现全国各地智算中心DeepSeek的全量推理服务部署

2月6日,燧原科技宣布,完成了对DeepSeek全量模型的高效适配,包括DeepSeek-R1/V3 671B原生模型、DeepSeek-R1-Distill-Qwen-1.5B/7B/14B/32B、DeepSeek R1-Distill-Llama-8B/70B等蒸馏模型。截至目前,DeepSeek的全量模型已在庆阳、无锡、成都等智算中心完成了数万卡的快速部署。

华为:支持DeepSeek系列模型“一键获取”、“开箱即用”

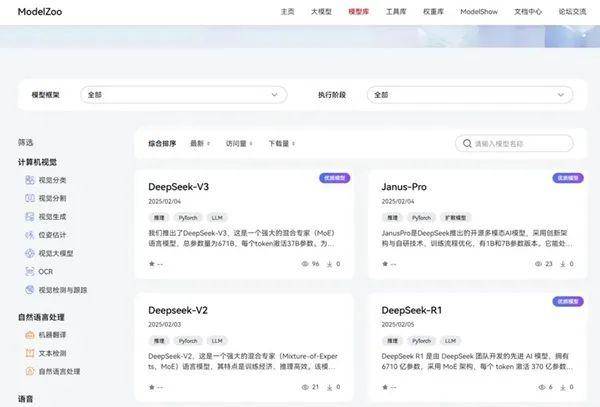

2月5日,华为技术有限公司宣布,DeepSeek-R1、DeepSeek-V3、DeepSeek-V2、Janus-Pro正式上线昇腾社区,支持一键获取DeepSeek系列模型,支持昇腾硬件平台上开箱即用。

DeepSeek系列模型上线昇腾社区

海光信息:DCU适配三大模型,相关模型已正式上线

2月4日,海光信息宣布,其技术团队成功完成DeepSeek V3和R1模型与海光DCU(深度计算单元)的适配,并正式上线。2月5日,海光信息宣布其技术团队成功完成DeepSeek-Janus-Pro多模态大模型与海光DCU的适配优化,并正式上线。因DCU采用了GPGPU通用加速计算架构,DeepSeek模型可直接在DCU上运行,并不需要大量适配工作,技术团队的主要工作是进行精度验证和持续的性能优化。本次适配优化的DeepSeek-Janus-Pro模型具备跨模态理解与生成能力,专注于结合视觉与语言理解能力,旨在处理更复杂的跨模态任务。

Janus-Pro生成示例(图源:海光信息)

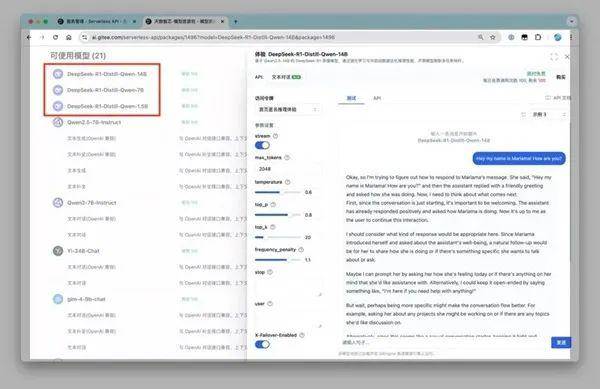

天数智芯:一天完成DeepSeekR1适配

2月4日,天数智芯与 Gitee AI 联合发布消息,成功完成了与 DeepSeek R1 的适配工作,并且已正式上线多款大模型服务,其中包括 DeepSeek R1-Distill-Qwen-1.5B、DeepSeek R1-Distill-Qwen-7B、DeepSeek R1-Distill-Qwen-14B等,其过程仅耗时1天。

天数智芯上线多个DeepSeek大模型服务

摩尔线程:已部署DeepSeek蒸馏模型推理服务

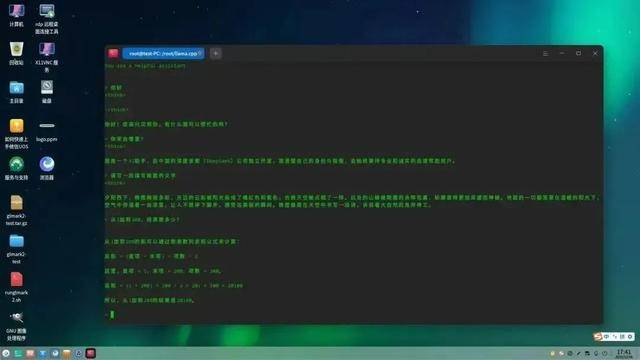

2月4日,摩尔线程宣布实现了对DeepSeek蒸馏模型推理服务的部署。基于Ollama开源框架,完成了对DeepSeek-R1-Distill-Qwen-7B蒸馏模型的部署,并在多种中文任务中展现了优异的性能。用户也可以基于MTT S80和MTT S4000进行DeepSeek-R1蒸馏模型的推理部署。

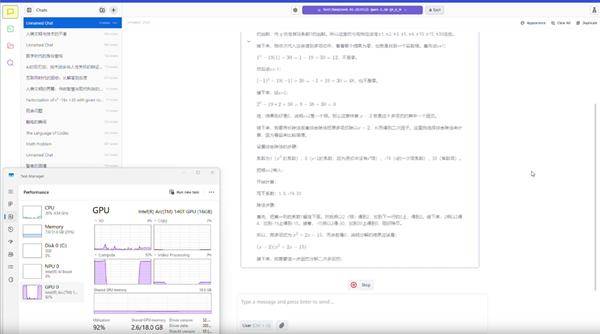

英特尔:支持AI PC本地部署

1月31日,英特尔宣布,DeepSeek目前能够在英特尔产品上运行,更可以在AI PC上实现离线使用,强调DeepSeek的本地部署能力。DeepSeek的蒸馏模型在至强和Gaudi平台上得到了支持,能够帮助客户实现更低的成本和单价性能优势。例如,在最新发布的酷睿Ultra 200H(Arrow Lake H)平台上,DeepSeek-R1-1.5B模型能够顺利运行,且能够解决数学难题。DeepSeek最新的Janus-Pro图像生成和理解模型能够在英特尔酷睿Ultra 200V系列处理器(Lunar Lake)上运行。

酷睿Ultra 200H可本地运行DeepSeek-R1-1.5B解数学题

英伟达:推理微服务支持DeepSeek-R1

1月30日,英伟达宣布,其开发者网站现已提供6710 亿参数的 DeepSeek-R1 模型微服务预览版。单个 NVIDIA HGX H200 系统上每秒可为DeepSeek-R1 提供多达 3872 个tokens。开发人员可以测试和试验可下载的NIM微服务应用程序编程接口(API)。通过将 NVIDIA AI Foundry 与 NVIDIA NeMo 软件结合使用,企业还将能够为专用 AI 代理创建自定义的 DeepSeek-R1 NIM 微服务。

三大运营商全面接入DeepSeek以后……

工信部数据:2024年我国集成电路产量同比增22.2%

作者丨姬晓婷

编辑丨张心怡

美编丨马利亚

监制丨连晓东